Identificamos uma instabilidade no servidor PRO115, que já está sendo verificada pela equipe responsável. Assim que tivermos mais detalhes, informaremos neste mesmo status de rede.

Contato para Suporte:

WhatsApp: https://wa.me/551113010000

Ticket: https://painel.napoleon.com.br/submitticket.php

Identificamos uma instabilidade no banco de dados no servidor PRO108. Nossa equipe já está verificando a situação e, assim que tivermos mais informações, atualizaremos este mesmo status de rede.

Suporte:

- WhatsApp: https://wa.me/11913010000

Resumo:

Neste sábado será realizada uma manutenção programada no servidor pro104.dnspro.com.br para substituição de um disco por outro de mesmo tamanho, seguida da reconfiguração do array do sistema operacional.

Durante a janela de manutenção, todos os serviços hospedados neste servidor ficarão temporariamente indisponíveis (offline). A atividade é necessária para garantir a estabilidade, segurança e continuidade do ambiente após a conclusão dos trabalhos.

Janela Prevista para Execução:

Início: 17/01/2026 às 23h

Conclusão: 18/01/2026 às 01h

Descrição Técnica:

- Motivo da Manutenção: Substituição preventiva de disco.

- Sintomas Observados: Necessidade de troca do componente físico.

Ações Planejadas:

- Desligamento controlado do servidor.

- Substituição do disco por um novo de mesmo tamanho.

- Reconstrução do array do sistema operacional.

- Verificações de integridade e funcionamento.

Recursos Afetados:

- Servidor: pro104.dnspro.com.br

- Todos os serviços hospedados, que permanecerão offline durante a execução.

Suporte:

- WhatsApp: https://wa.me/11913010000

Identificamos uma instabilidade no servidor PRO127, que já está sendo verificada pela equipe responsável. Assim que tivermos mais detalhes, informaremos neste mesmo status de rede.

A equipe do Data Center foi acionada e já está atuando nos ajustes necessários para a normalização do ambiente.

A equipe do Data Center segue trabalhando ativamente na normalização da rede do ambiente, realizando os ajustes necessários e monitorando a estabilidade.

Atualização: O problema foi resolvido e os acessos já se encontram normalizados. A equipe do Data Center realizou ajustes na rede para correção da instabilidade identificada.

O ambiente segue estável e permanece em monitoramento preventivo para garantir que a normalização se mantenha de forma definitiva.

Contato para Suporte:

WhatsApp: https://wa.me/551113010000

Ticket: https://painel.napoleon.com.br/submitticket.php

Resumo:

Será realizada uma manutenção programada no servidor pro104.dnspro.com.br para substituição de um disco por outro de mesmo tamanho, seguida da reconfiguração do array do sistema operacional.

Durante a janela de manutenção, todos os serviços hospedados neste servidor ficarão temporariamente indisponíveis (offline). A atividade é necessária para garantir a estabilidade, segurança e continuidade do ambiente após a conclusão dos trabalhos.

Janela Prevista para Execução:

Início: 13/01/2026 às 23h

Conclusão: 14/01/2026 às 01h

Descrição Técnica:

- Motivo da Manutenção: Substituição preventiva de disco.

- Sintomas Observados: Necessidade de troca do componente físico.

Ações Planejadas:

- Desligamento controlado do servidor.

- Substituição do disco por um novo de mesmo tamanho.

- Reconstrução do array do sistema operacional.

- Verificações de integridade e funcionamento.

Recursos Afetados:

- Servidor: pro104.dnspro.com.br

- Todos os serviços hospedados, que permanecerão offline durante a execução.

Suporte:

- WhatsApp: https://wa.me/11913010000

Parte de nossa rede nacional está sendo impactada por instabilidades globais de roteamento da Cirion. O problema também afeta rotas da América do Sul para parte dos servidores hospedados nos Estados Unidos. As equipes de engenharia de nossos data centers já estão atuando para ajustar as rotas afetadas e normalizar o tráfego.

22:34 - Restauração das tabelas Innodb em andamento. Recomendamos não alterar o banco de dados neste momento.

21:24 - Ainda em investigação.

20:59 - Em investigação.

Resumo do Problema:

Estamos enfrentando uma instabilidade que afeta os serviços hospedados no servidor PRO115. Nossa equipe técnica já está atuando de forma contínua na análise da causa e na implementação das medidas corretivas necessárias para restabelecer a normalidade do ambiente o mais breve possível.

Previsão de Normalização:

Ainda sem previsão definida. A equipe segue em monitoramento e atuação ativa.

Descrição Técnica:

No momento, foi identificada uma instabilidade geral no servidor PRO115, impactando os serviços hospedados. A equipe técnica iniciou os procedimentos de diagnóstico e análise detalhada para identificar a origem da ocorrência e aplicar as correções necessárias.

Próximos Passos:

-

Continuidade da investigação técnica para identificar a causa raiz.

-

Aplicação de medidas corretivas assim que identificada a origem do problema.

-

Atualizações serão publicadas assim que houver novas informações.

Contato para Suporte:

WhatsApp: https://wa.me/551113010000

Ticket: https://painel.napoleon.com.br/submitticket.php

Resumo do Problema:

Estamos identificando uma instabilidade no servidor PRO113. Nossa equipe técnica já está realizando a análise dos logs e métricas do ambiente para identificar a causa raiz. A equipe de redes também foi acionada e está atuando na verificação para garantir a normalização do ambiente.

Previsão de Normalização:

As equipes técnica e de redes seguem em atuação contínua para identificar e corrigir a causa da instabilidade. A normalização completa do ambiente está prevista para ocorrer assim que as medidas corretivas forem aplicadas e validadas. Atualizaremos este status assim que tivermos um novo feedback.

Descrição Técnica:

-

Sintoma observado: Instabilidade no acesso aos serviços hospedados no servidor PRO113.

-

Ações iniciais: A equipe técnica iniciou a análise dos logs e métricas do ambiente para identificar possíveis falhas.

-

Sistemas e recursos afetados: Serviços hospedados no servidor PRO113.

-

Equipe envolvida: Equipe técnica e equipe de redes, atuando de forma conjunta.

Suporte:

WhatsApp: https://wa.me/551113010000

Ticket: https://painel.napoleon.com.br/submitticket.php

Resumo do Problema:

Estamos identificando uma instabilidade no servidor PRO113. Nossa equipe técnica já está realizando a análise dos logs e métricas do ambiente para identificar a causa raiz. A equipe de redes também foi acionada e está atuando na verificação para garantir a normalização do ambiente.

Previsão de Normalização:

As equipes técnica e de redes seguem em atuação contínua para identificar e corrigir a causa da instabilidade. A normalização completa do ambiente está prevista para ocorrer assim que as medidas corretivas forem aplicadas e validadas. Atualizaremos este status assim que tivermos um novo feedback.

Descrição Técnica:

-

Sintoma observado: Instabilidade no acesso aos serviços hospedados no servidor PRO113.

-

Ações iniciais: A equipe técnica iniciou a análise dos logs e métricas do ambiente para identificar possíveis falhas.

-

Sistemas e recursos afetados: Serviços hospedados no servidor PRO113.

-

Equipe envolvida: Equipe técnica e equipe de redes, atuando de forma conjunta.

Suporte:

WhatsApp: https://wa.me/551113010000

Ticket: https://painel.napoleon.com.br/submitticket.php

Identificamos uma instabilidade no servidor PRO122. Nossa equipe técnica já está atuando para diagnosticar e corrigir a causa do problema.

Assim que houver novas informações ou a normalização do serviço, atualizaremos este status de rede.

Agradecemos pela compreensão.

Suporte:

WhatsApp: https://wa.me/551113010000

Ticket: https://painel.napoleon.com.br/submitticket.php

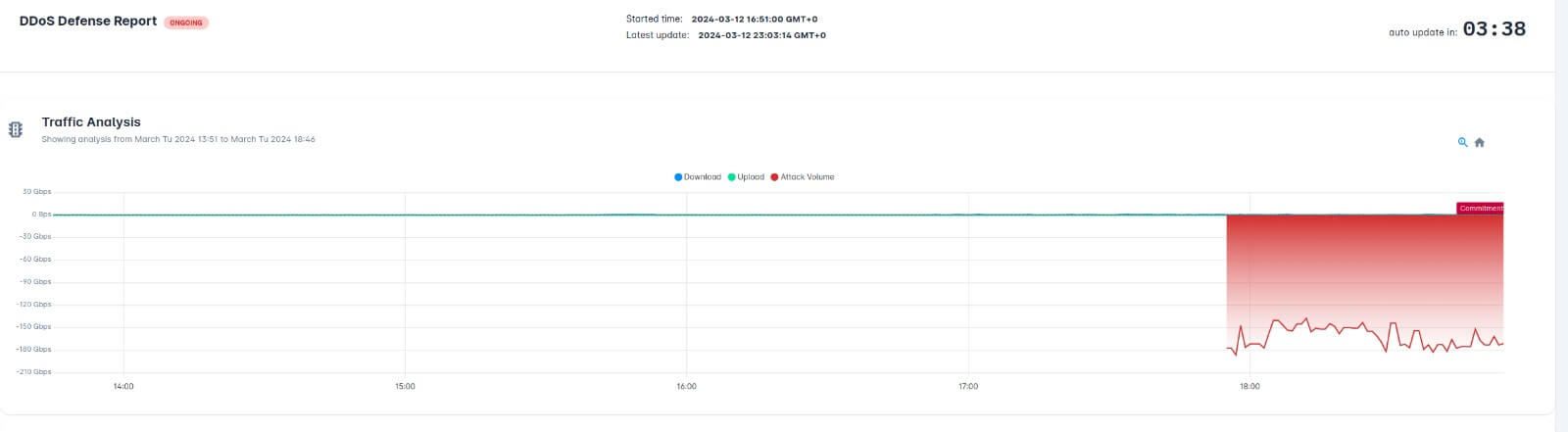

Resumo do Problema:

Foi identificada uma instabilidade no servidor PRO 104, responsável pela hospedagem de diversos sites e sistemas. O problema está relacionado a um ataque UDP de grande escala direcionado à rede do servidor, o que impactou temporariamente o acesso aos serviços hospedados.

A equipe de engenharia de rede está atuando com prioridade máxima, em conjunto com a UPX, para mitigar o ataque e restaurar completamente a estabilidade do ambiente.

Previsão de Normalização:

Ainda sem previsão definida. O ambiente permanecerá sob monitoramento contínuo até a completa neutralização do ataque.

Descrição Técnica:

-

Sintomas observados: indisponibilidade e instabilidade nos sites e serviços hospedados no servidor PRO 104.

-

Causa identificada: ataque UDP de grande escala direcionado à infraestrutura de rede que hospeda o servidor.

-

Ações iniciais: análise de logs, verificação de integridade do servidor e ajuste nas regras de Anti-DDoS.

-

Recursos afetados: serviços e sites hospedados no servidor PRO 104.

-

Status atual: a equipe de redes, em conjunto com a UPX, está ajustando as configurações de mitigação do Anti-DDoS para estabilizar a comunicação. Durante o processo, podem ocorrer momentos de oscilação no acesso, especialmente quando há mudança na assinatura do ataque.

Próximos Passos:

-

Continuação da análise técnica e monitoramento ativo do tráfego.

-

Aplicação de novas regras de mitigação conforme a evolução do ataque.

-

Comunicação contínua com a UPX para garantir a eficácia das medidas.

-

Publicação de novas atualizações assim que houver progresso na normalização.

Suporte:

-

WhatsApp: https://wa.me/551113010000

Identificamos uma instabilidade no servidor PRO122. Nossa equipe já está atuando para restabelecer a normalidade do serviço.

Atualização [26/09/2025 - 23:12]: Estamos verificando a situação junto ao time de redes do data center. Assim que tivermos novas informações, atualizaremos o status por aqui.

Identificamos uma instabilidade no servidor PRO127. Nossa equipe já está atuando na análise do ocorrido e, assim que tivermos novas informações, atualizaremos este status de rede.

Atualização - A instabilidade identificada no servidor PRO127 foi devidamente corrigida pela nossa equipe técnica. O ambiente encontra-se estável e monitorado.

Caso tenha qualquer dúvida ou precise de suporte adicional, permanecemos totalmente à disposição para auxiliar.

Estamos enfrentando uma instabilidade no servidor PRO114.

Identificamos falhas no sistema de RAID, que estão sendo avaliadas pela nossa equipe técnica. Já iniciamos a investigação e novas informações serão repassadas assim que possível.

Atualização: Foi inicializado um ambiente Live USB do AlmaLinux para execução de diagnósticos no array RAID, com o objetivo de verificar a integridade dos discos e identificar se a origem da falha está relacionada ao sistema (camada de software) ou a problemas físicos no hardware do array.

Atualização 1.2: Os serviços afetados já estão online.

No momento, estamos aguardando o parecer técnico completo sobre a causa da instabilidade, que envolveu falhas no array RAID.

Seguimos monitorando o ambiente e, assim que houver mais detalhes sobre o ocorrido, este status será atualizado.

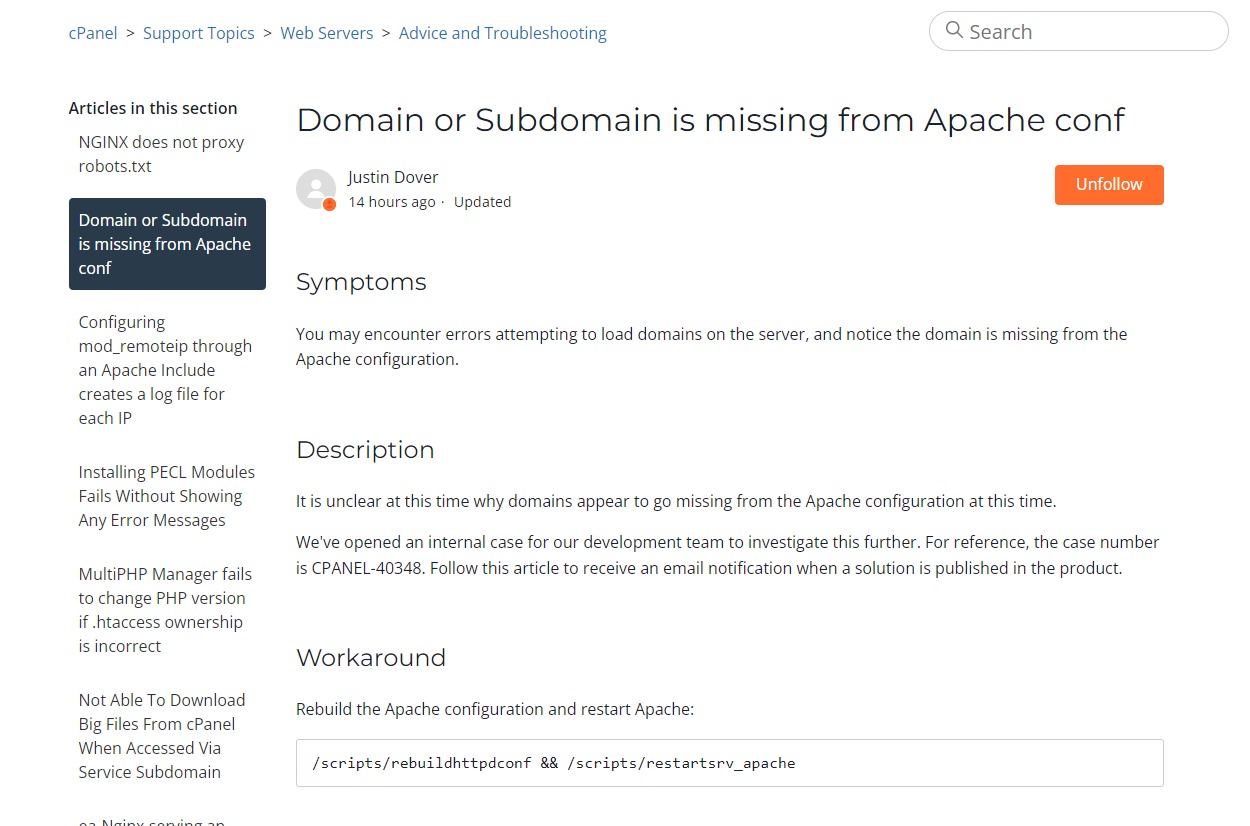

Atualização – Servidor PRO114: Migração Emergencial em Andamento

Em decorrência da falha identificada no array RAID do servidor PRO114, e visando garantir a estabilidade e integridade dos serviços hospedados, decidimos realizar a migração emergencial de todas as contas para novos servidores com infraestrutura estável e validada.

Detalhes técnicos da ação:

-

A falha no array RAID comprometeu a confiabilidade do ambiente atual, exigindo análise e recuperação por meio de um ambiente Live USB do AlmaLinux, que identificou riscos de degradação nos discos.

-

Para preservar os dados e reduzir o risco de futuras instabilidades, estamos realizando a restauração completa dos backups em servidores distintos, com hardware íntegro e monitoramento ativo.

-

A migração inclui todos os dados da conta (arquivos, bancos de dados, e-mails e configurações) e está sendo tratada com prioridade máxima pela nossa equipe técnica.

Informações para os clientes:

-

Assim que a restauração da conta for finalizada no novo servidor, um ticket será aberto automaticamente na conta do cliente com:

-

A confirmação da finalização do processo;

-

O novo endereço IP do servidor.

-

Importante sobre DNS externo:

-

Para clientes que utilizam zona de DNS externa (como Cloudflare, Amazon Route 53, etc.), será necessário atualizar manualmente os registros DNS, apontando para o novo IP informado no ticket.

-

O apontamento correto garantirá o funcionamento do domínio após a migração.

Seguimos monitorando e acompanhando cada conta de forma individualizada para garantir que a transição ocorra da forma mais segura e rápida possível.

Agradecemos pela compreensão e reforçamos nosso compromisso com a estabilidade da sua aplicação.

Suporte:

WhatsApp: Clique aqui

Ticket: Acesse o painel

Identificamos uma instabilidade no banco de dados do servidor PRO113. Nosso time técnico já está atuando na verificação e correção do problema.

Manteremos este status atualizado assim que houverem novas informações.

Atualização: Houve um travamento no serviço de banco de dados do servidor PRO113, que já foi devidamente corrigido pela nossa equipe técnica.

Seguimos monitorando o ambiente para garantir a estabilidade.

Agradecemos a compreensão.

Agradecemos a compreensão.

Equipe Técnica Napoleon

Resumo do Problema:

Foi identificada uma falha de memória em um dos servidores físicos responsáveis pela hospedagem das VPS nacionais. Como medida corretiva, será realizada uma manutenção emergencial com substituição do componente afetado.

Durante a janela de manutenção, as VPS hospedadas neste servidor ficarão offline temporariamente, com previsão de normalização após o término do procedimento.

Previsão de Normalização:

A intervenção está agendada para a madrugada de sexta para sábado, às 00h, com duração estimada de 1 hora.

Descrição Técnica:

A equipe técnica identificou uma falha em um módulo de memória em um servidor físico utilizado para hospedagem de VPS nacionais. Após validações internas, foi confirmada a necessidade de substituição do componente para evitar comprometimento da estabilidade do ambiente. A manutenção será executada de forma emergencial para prevenir falhas mais graves.

Próximos Passos:

-

Realizar a substituição do módulo de memória durante a janela agendada.

-

Monitorar o ambiente após a manutenção para garantir total estabilidade.

-

Comunicar os clientes sobre a finalização da intervenção.

-

Atualizações serão registradas durante o processo, se necessário.

Equipe técnica,

Napoleon.

Estamos enfrentando uma instabilidade momentânea no servidor PRO114.

Nossa equipe já está investigando o ocorrido e novas informações serão repassadas assim que possível.

Agradecemos pela compreensão.

00:13 - PRO115 online, foi atualizado 03 (três) firmwares e a maquina conseguiu subir. BIOS, Controladora e IDRAC.

23:42 - O nosso plantonista esta se deslocando ao Data Center.

23:27 - Ainda em analise do hardware.

22:45 - Em investigação:

Problema que resultou na reinicialização da máquina e não inicialização correta do hardware.

Resumo:

O servidor PRO119 apresentou uma instabilidade que impactou diretamente o acesso ao servidor. O problema está relacionado a uma falha elétrica no rack onde o equipamento está hospedado. Com isso, clientes podem ter enfrentado indisponibilidade total ou parcial dos serviços hospedados neste servidor. A equipe técnica do data center já está atuando para normalização.

Descrição Técnica:

-

Sintomas Observados: Indisponibilidade de acesso ao servidor PRO119.

-

Ações Iniciais: A equipe técnica iniciou imediatamente a investigação do incidente.

-

Causa Identificada: Falha elétrica afetando o rack onde o servidor está alocado.

-

Sistemas Afetados: Todos os serviços hospedados no servidor PRO119.

Próximos Passos:

- Continuidade na investigação junto à infraestrutura elétrica do data center.

- Acompanhamento técnico com prioridade máxima até a normalização completa.

- Novas atualizações serão publicadas neste canal conforme o progresso.

Suporte:

WhatsApp: https://wa.me/55111301000

Abertura de Ticket: https://painel.napoleon.com.br/submitticket.php

Estamos enfrentando uma instabilidade momentânea no servidor PRO115.

Nossa equipe já está investigando o ocorrido e novas informações serão repassadas assim que possível.

Agradecemos pela compreensão.

Resumo:

Será realizada uma manutenção no servidor PRO125 para substituição do slot de conexão da controladora na placa-mãe, que apresentou inconsistência após a troca recente da controladora e do disco NVMe. Durante o procedimento, todos os serviços hospedados neste servidor ficarão temporariamente offline.

Data e Hora:

Hoje, 20/07/2025

Início às 23h00 (horário de Brasília)

Janela estimada de conclusão: até 1 hora

Detalhes Técnicos:

- Motivo: Substituição do slot de conexão da controladora na placa-mãe devido a inconsistência detectada

- Impacto: Indisponibilidade total dos serviços hospedados no servidor durante o período

- Recursos Afetados: Aplicações e serviços hospedados no servidor PRO125

- Reinicialização: Sim, será realizada como parte do procedimento

- Monitoramento: Após a conclusão, o ambiente será monitorado para garantir a estabilidade operacional

Próximos Passos:

-

Substituição do slot de conexão da controladora

-

Reinicialização do servidor e validação dos serviços

-

Monitoramento contínuo após a manutenção

Suporte:

Resumo:

Será realizada uma manutenção preventiva no servidor PRO125, com o objetivo de garantir maior estabilidade, desempenho e confiabilidade do ambiente. Durante a manutenção, todos os serviços hospedados nesse servidor ficarão temporariamente offline.

Data e Hora:

20/07/2025

Início às 01h00 (horário de Brasília)

Duração estimada: até 2 horas

Detalhes Técnicos:

-

Tipo de Manutenção: Preventiva

-

Motivo: Troca da controladora do servidor

-

Impacto: Indisponibilidade temporária de todos os serviços hospedados no PRO125

-

Recursos Afetados: Aplicações e serviços hospedados no servidor

-

Reinicialização: Sim, será realizada como parte do procedimento

-

Monitoramento: Após a conclusão, o ambiente será acompanhado para garantir estabilidade e funcionamento pleno

Próximos Passos:

-

Troca da controladora conforme o agendamento

-

Reinicialização do servidor e validação dos serviços

3. Monitoramento contínuo do ambiente após a finalização

Suporte:

Resumo:

Foi realizada com sucesso a substituição preventiva de disco no servidor PRO125, com início às 00h00 do dia 18/07. A intervenção foi concluída em aproximadamente 20 minutos, e o servidor foi normalizado às 00h30.

Neste momento, os serviços estão ativos e operando normalmente. O processo de rebuild do RAID segue em segundo plano e não afeta a disponibilidade da máquina ou dos serviços hospedados.

Status Atual:

✅ Servidor online e operacional desde 00h30 do dia 18/07/2025.

✅ Rebuild do RAID em andamento sem impacto aos serviços.

Descrição Técnica:

- Tipo de Manutenção: Preventiva.

- Motivo: Substituição de disco com falha no array RAID do servidor PRO125.

- Impacto: Breve indisponibilidade de cerca de 20 minutos durante a troca física do disco.

- Status Atual: Serviços normalizados, rebuild em segundo plano.

Próximos Passos:

- Monitoramento contínuo do processo de rebuild do RAID.

- Não há ações adicionais exigidas dos usuários neste momento.

- Atualizações serão publicadas apenas se houver qualquer alteração relevante no status do rebuild.

Contato para Suporte:

- WhatsApp: https://wa.me/551113010000

- Ticket: https://painel.napoleon.com.br/submitticket.php

Identificamos uma instabilidade no servidor PRO114, que está afetando o acesso aos sites hospedados.

Nosso time técnico já está trabalhando para resolver o problema o mais rápido possível. Ainda não há um prazo definido para a normalização, mas atualizaremos este status assim que tivermos novidades.

Atualização: Identificamos que a instabilidade no servidor PRO114 foi causada por um travamento no servidor de banco de dados, o que afetou o acesso aos sites hospedados.

Nossa equipe técnica precisou intervir manualmente para normalizar a situação, e os serviços já foram restabelecidos.

Seguimos monitorando para garantir a estabilidade. Agradecemos pela compreensão.

Identificamos uma instabilidade no servidor PRO125 e nosso time técnico já está trabalhando para resolver o mais rápido possível.

Ainda não temos um prazo definido para normalização, mas atualizaremos este status assim que tivermos novidades.

Atualização: Reiniciamos a máquina após perdermos o acesso ao IPMI por um motivo ainda não identificado. Após o reinício, o acesso foi normalizado e os serviços estão funcionando normalmente.

Seguimos monitorando para garantir a estabilidade.

Agradecemos pela compreensão.

Equipe técnica.

Foi identificada uma instabilidade no IX.br São Paulo, que afetou parcialmente a matriz de comutação. Isso causou falhas de roteamento para operadoras, impactando o acesso a servidores nacionais localizados no datacenter SP1. Clientes relataram perda parcial de conectividade com serviços hospedados nesse ambiente.

Previsão de Normalização:

Ambiente normalizado às 12h35. Equipe segue monitorando.

Descrição Técnica:

-

Perda parcial de tráfego e falhas de acesso via operadoras.

-

Ação conjunta da HDBR e operadoras identificou o ponto de falha no IX.br.

-

Ajuste de rotas realizado com sucesso.

Próximos Passos:

-

Monitoramento contínuo da estabilidade.

-

Análise com operadoras e IX.br.

-

Atualizações conforme necessário.

Atualizações:

-

12h35: Tráfego normalizado.

-

12h40: Início do monitoramento.

-

12h46: Status estável mantido.

Contato para Suporte Napoleon:

???? WhatsApp: https://wa.me/5511913010000

???? Ticket: https://painel.napoleon.com.br/submitticket.php

Estamos enfrentando uma instabilidade momentânea no servidor PRO115.

Nossa equipe já está investigando o ocorrido e novas informações serão repassadas assim que possível.

Agradecemos pela compreensão.

Resumo do Problema:

Estamos enfrentando uma instabilidade intermitente no datacenter SP1, o que pode afetar o acesso aos serviços hospedados nessa localidade. Nossa equipe de engenharia já está analisando o incidente com prioridade máxima para identificar a causa e aplicar as medidas corretivas necessárias.

Os clientes podem notar dificuldades de acesso momentâneas aos seus serviços hospedados em SP1.

Previsão de Normalização:

Ainda em análise. Nova atualização será publicada em até 30 minutos.

Descrição Técnica:

-

Sintomas observados: Intermitência no acesso aos serviços no datacenter SP1.

-

Ações iniciais: Monitoramento identificou a falha. Equipe técnica iniciou a análise das evidências.

-

Recursos afetados: Serviços hospedados em SP1, com possível impacto parcial no acesso.

Próximos Passos:

-

Continuação da análise técnica por especialistas.

-

Identificação da causa raiz do problema.

-

Aplicação das tratativas corretivas

<> Nova atualização será publicada através deste status

Agradecemos a compreensão. Equipe Técnica

Estamos realizando uma manutenção emergencial no servidor PRO105 para garantir a estabilidade e o desempenho dos serviços. No momento, o servidor pode apresentar indisponibilidade temporária.

Nossa equipe técnica está atuando com prioridade máxima, e em breve traremos novas informações.

[Atualização - 10:37]

Houve uma falha na montagem do array RAID da partição raiz do servidor, o que ocasionou o seu travamento.

Foi realizada uma manutenção emergencial, incluindo a análise dos discos, que se mostraram saudáveis. Após essa verificação, o array RAID foi devidamente remontado, restabelecendo o funcionamento normal do sistema.

Agradecemos pela compreensão e paciência.

Informamos que foi registrada uma instabilidade no node físico responsável por hospedar a sua VPS, que resultou na queda completa do servidor e posterior necessidade de reinicialização manual.

Após análise preliminar, foi identificado que a falha não se restringiu à VPS isoladamente, mas afetou o ambiente físico como um todo.

Diante disso, abrimos uma solicitação formal junto à nossa equipe técnica de infraestrutura, para investigação aprofundada do ocorrido. Como medida preventiva, está agendada uma intervenção técnica na máquina para o dia 13/06 (sexta-feira) da 01:00 às 03:00 com o objetivo de garantir a estabilidade e continuidade dos serviços.

Manteremos todos os envolvidos informados quanto aos avanços da apuração e conclusões da manutenção.

Agradecemos a compreensão e seguimos à disposição.

Atenciosamente,

Equipe Técnica – Napoleon

Identificada a queda da máquina PRO126, que atualmente se encontra offline. Os serviços hospedados neste servidor estão indisponíveis para os clientes. A equipe técnica já está atuando com prioridade máxima para diagnosticar o ocorrido e restabelecer o funcionamento no menor tempo possível.

Atualização: A máquina foi restabelecida e encontra-se operando normalmente. Todos os serviços hospedados no servidor já estão acessíveis. A equipe técnica segue com as investigações internas para identificar a causa raiz e garantir a estabilidade contínua.

Informamos que foi registrada uma instabilidade no node físico responsável por hospedar a sua VPS, que resultou na queda completa do servidor e posterior necessidade de reinicialização manual.

Após análise preliminar, foi identificado que a falha não se restringiu à VPS isoladamente, mas afetou o ambiente físico como um todo. A principal suspeita até o momento recai sobre um possível defeito na controladora NVMe.

Diante disso, abrimos uma solicitação formal junto à nossa equipe técnica de infraestrutura, para investigação aprofundada do ocorrido. Como medida preventiva, está agendada uma intervenção técnica na máquina para o dia 10/06 (terça-feira) às 23hrs com o objetivo de garantir a estabilidade e continuidade dos serviços.

Manteremos todos os envolvidos informados quanto aos avanços da apuração e conclusões da manutenção.

Agradecemos a compreensão e seguimos à disposição.

Atenciosamente,

Equipe Técnica – Napoleon

Informamos que foi registrada uma instabilidade no node físico responsável por hospedar a sua VPS, que resultou na queda completa do servidor e posterior necessidade de reinicialização manual.

Após análise preliminar, foi identificado que a falha não se restringiu à VPS isoladamente, mas afetou o ambiente físico como um todo. A principal suspeita até o momento recai sobre um possível defeito na controladora NVMe.

Diante disso, abrimos uma solicitação formal junto à nossa equipe técnica de infraestrutura, para investigação aprofundada do ocorrido. Como medida preventiva, está agendada uma intervenção técnica na máquina para o dia 05/06 (quinta-feira) às 23hrs com o objetivo de garantir a estabilidade e continuidade dos serviços.

Manteremos todos os envolvidos informados quanto aos avanços da apuração e conclusões da manutenção.

Agradecemos a compreensão e seguimos à disposição.

Atenciosamente,

Equipe Técnica – Napoleon

Resumo:

Será realizada uma manutenção programada no servidor Enhance com início à 00h desta madrugada para substituição da controladora. Durante a janela de manutenção, ocorrerá a indisponibilidade total no acesso aos sites dos clientes hospedados nesse servidor. A ação é necessária para garantir maior estabilidade e desempenho futuro.

Previsão de Normalização:

Até as 02h da madrugada (duração estimada de 2 horas)

Descrição Técnica:

-

Sintomas observados: Ação preventiva. A troca da controladora foi agendada para garantir a integridade e o desempenho do sistema.

-

Ações iniciais: Equipe agendou manutenção e notificou os responsáveis.

-

Sistemas afetados: Todos os serviços hospedados no servidor Enhance.

-

Impacto: Parada total dos serviços durante a manutenção.

Próximos Passos:

-

Início da manutenção à 00h.

-

Substituição da controladora por novo equipamento.

-

Testes de funcionamento e reinicialização dos serviços.

-

Monitoramento ativo após finalização para garantir estabilidade.

Atenciosamente,

Equipe Técnica – Napoleon

Informamos que foi registrada uma instabilidade no node físico responsável por hospedar a sua VPS, que resultou na queda completa do servidor e posterior necessidade de reinicialização manual.

Após análise preliminar, foi identificado que a falha não se restringiu à VPS isoladamente, mas afetou o ambiente físico como um todo. A principal suspeita até o momento recai sobre um possível defeito na controladora NVMe.

Diante disso, abrimos uma solicitação formal junto à nossa equipe técnica de infraestrutura, para investigação aprofundada do ocorrido. Como medida preventiva, está agendada uma intervenção técnica na máquina para o dia 24/05 (sábado), às 01h00 - nesta madrugada, com o objetivo de garantir a estabilidade e continuidade dos serviços.

Manteremos todos os envolvidos informados quanto aos avanços da apuração e conclusões da manutenção.

Agradecemos a compreensão e seguimos à disposição.

Atenciosamente,

Equipe Técnica – Napoleon

Informamos que foi registrada uma instabilidade no node físico responsável por hospedar as VPS Nacionais, resultando na queda completa do servidor e na necessidade de reinicialização manual.

Após análise preliminar, identificamos que a falha não se restringiu à uma VPS em específico, mas afetou o ambiente físico como um todo. A principal suspeita, até o momento, recai sobre um possível defeito na controladora NVMe.

Diante disso, abrimos uma solicitação formal junto à nossa equipe técnica de infraestrutura para investigação aprofundada do ocorrido. Como medida preventiva, está agendada uma intervenção técnica na máquina para o dia 23/05 (sexta-feira), às 01h00 — nesta madrugada — com o objetivo de garantir a estabilidade e continuidade dos serviços.

Manteremos todos os envolvidos informados sobre os avanços da apuração e as conclusões da manutenção.

Agradecemos a compreensão e seguimos à disposição.

Atenciosamente,

Equipe Técnica – Napoleon

Resumo do Problema:

Identificamos uma instabilidade no acesso web ao servidor PRO108, causada por um ataque DDoS direcionado à sua rede. A equipe de infraestrutura está atuando ativamente para mitigar os efeitos e restabelecer a normalidade o quanto antes. Durante esse processo, os clientes podem notar lentidão no carregamento dos sites hospedados.

Previsão de Normalização:

Ainda não há prazo definido para normalização completa, mas as ações corretivas já estão em andamento.

Descrição Técnica:

- Sintomas observados: Lentidão no acesso a sites hospedados no servidor PRO108.

- Ações iniciais: Início imediato do processo de mitigação do ataque DDoS.

- Recursos afetados: Acesso web (HTTP/HTTPS).

Próximos Passos:

- A equipe continua a aplicar regras de mitigação e monitoramento em tempo real para neutralizar o ataque.

- Atualizações serão fornecidas conforme o progresso das ações técnicas, através de nossos canais oficiais.

Atualização: O servidor foi normalizado e seguimos o monitoramento do mesmo.

Contato para Suporte:

-

WhatsApp: https://wa.me/11913010000

Resumo do Incidente:

Estamos enfrentando uma instabilidade no acesso aos sites hospedados no servidor PRO123. O problema afeta a experiência de navegação dos clientes, podendo ocasionar lentidão ou falhas intermitentes de carregamento. Nossa equipe já está atuando na mitigação da causa identificada.

Previsão de Normalização:

No momento, ainda não há um prazo estimado para a normalização, mas a equipe técnica já está atuando na correção do problema.

Descrição Técnica:

Foi identificada uma dificuldade de roteamento que está impactando o acesso aos sites hospedados no servidor PRO123. Os sintomas observados incluem falhas intermitentes de acesso e instabilidade geral na navegação. A equipe técnica está atuando junto ao data center responsável para mitigar a falha e restabelecer a estabilidade do ambiente o quanto antes.

Próximos Passos:

A equipe técnica está em contato direto com o data center e segue atuando na correção do problema. Assim que houver novas informações relevantes ou a normalização do serviço, este status será atualizado. As atualizações serão publicadas exclusivamente por este canal de Status de Rede.

Suporte:

WhatsApp: https://api.whatsapp.com/send/?phone=5511913010000

Ticket: https://painel.napoleon.com.br/submitticket.php

Resolvido - A proteção de DDoS foi desativada, pois não havia ataque em nosso bloco de IP. Correção aplicada no PRO102 e situação normalizada.

Resumo do Problema:

O servidor PRO121 apresentou falhas de rede que estão afetando os sites hospedados, resultando em instabilidade geral e indisponibilidade no acesso. A equipe técnica está tratando o caso com prioridade máxima para restaurar a normalidade o quanto antes.

Previsão de Normalização:

No momento, ainda não é possível estimar um prazo para normalização.

Descrição Técnica:

Foi identificada a queda generalizada dos sites hospedados no servidor PRO121. A máquina foi reiniciada como medida inicial e agora está sendo conduzida uma investigação detalhada para identificar a causa raiz do possível problema na rede. O foco está em verificar conectividade, rotas e interfaces de rede.

Próximos Passos:

-

A equipe segue investigando o problema com foco na conectividade da rede.

-

Monitoramento contínuo está ativo para detectar qualquer mudança no comportamento do servidor.

-

Atualizações serão publicadas no painel e, se necessário, enviadas via WhatsApp para os clientes afetados.

Atualização:O acesso aos sites hospedados no servidor PRO121 está sendo restaurado gradativamente. A equipe técnica segue monitorando ativamente o ambiente para garantir a estabilidade total do serviço.

Contato para Suporte:

-

WhatsApp: https://wa.me/551113010000

-

Resumo do Problema:

O IX.SP, um ponto de troca de tráfego utilizado por diversos provedores no Brasil, está atualmente offline. Isso está causando instabilidades em rotas de rede por todo o país. No entanto, nossos servidores permanecem online e operacionais. O impacto se limita a dificuldades na conectividade para alguns clientes, dependendo do provedor de internet utilizado.

Previsão de Normalização:

Ainda não há uma previsão oficial para a normalização do IX.SP. Estamos monitorando o incidente e atualizaremos assim que houver novas informações.

Descrição Técnica:

-

Sintomas observados: Latência elevada, falhas de roteamento e dificuldade de acesso aos serviços devido à indisponibilidade do IX.SP.

-

Ações iniciais: Nossa equipe confirmou que os servidores permanecem operacionais e está acompanhando a situação junto aos provedores de trânsito.

-

Sistemas afetados: Conectividade de usuários que dependem de rotas impactadas pelo IX.SP.

Próximos Passos:

-

Monitoramento contínuo da situação junto aos provedores de trânsito e ao IX.SP.

-

Comunicação ativa com clientes para fornecer alternativas temporárias, se aplicável.

-

Atualizações periódicas conforme novas informações forem divulgadas.

Atualização do IX.BR:Caro Participante do IX.br São Paulo,

entre 11:31 e 11:33 UTC -3 do dia 25 de março de 2025 houve um loop layer 2 no peering fabric do IX.br São Paulo, causando indisponibilidade na ligação dos participantes conectados a essa localidade. O problema já foi identificado e corrigido pela equipe do IX.br e no momento a rede está operacional.

att.,

IX.br

Link do status completo deles: https://status.ix.br/Escrito por IX.SP

Suporte:WhatsApp: Clique aqui

Ticket: Acesse o painel

Resumo do Problema:

O servidor pro125 apresentou uma instabilidade que impacta o funcionamento dos serviços hospedados. Durante a manutenção emergencial para a troca do NVMe, os sites poderão apresentar instabilidade. A equipe técnica já está atuando para solucionar o problema o mais rápido possível.

Previsão de Normalização:

O procedimento tem um prazo estimado de 40 minutos para conclusão.

Descrição Técnica:

A instabilidade foi causada por uma falha em um dos SSDs NVMe localizados no slot PCI 1 do servidor pro125. Para restaurar a estabilidade do serviço, a equipe técnica está realizando a substituição emergencial do componente.

Próximos Passos:

A equipe já iniciou a troca do NVMe.

Após a substituição, serão realizados testes de integridade do sistema.

Assim que o processo for finalizado, será feita uma nova atualização sobre a normalização do serviço.

WhatsApp: Clique aqui

Ticket: Abrir chamado

Em investigação.

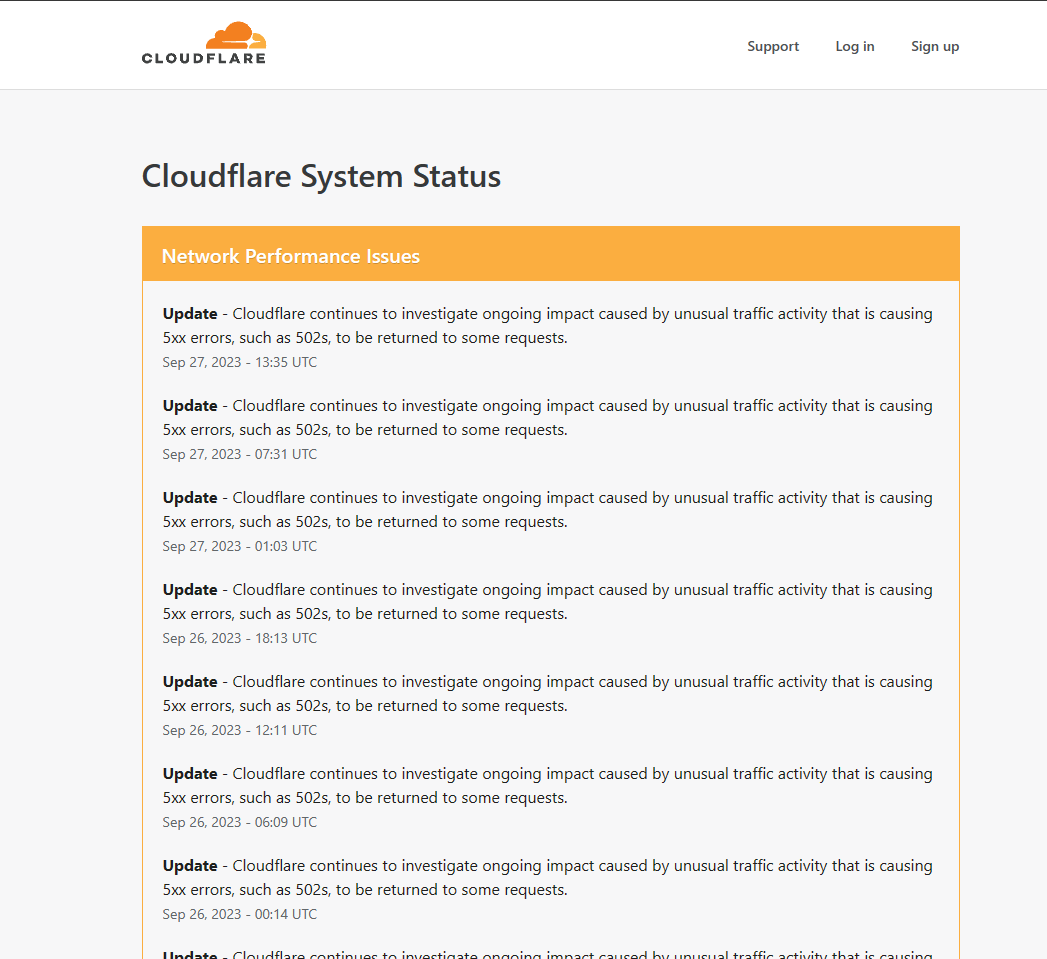

Resumo do Problema:

Detectamos instabilidade nos serviços da Cloudflare, impactando clientes que utilizam o serviço de proxy e proteção da plataforma. Esse problema pode resultar em dificuldades de acesso a sites, lentidão ou indisponibilidade intermitente. Como se trata de um serviço externo, a resolução depende exclusivamente da Cloudflare.

Previsão de Normalização:

Por se tratar de um serviço externo, não há previsão de normalização.

Descrição Técnica:

- Relatos de usuários e monitoramento indicam aumento significativo de falhas nos serviços da Cloudflare nas últimas horas.

- O problema pode afetar sites que utilizam o proxy da Cloudflare, causando falhas de carregamento ou erros intermitentes.

- A recomendação para clientes impactados é desativar temporariamente o proxy da Cloudflare (nuvem laranja), permitindo que o tráfego flua diretamente para o servidor de origem.

Próximos Passos:

- Continuaremos monitorando a situação e informando atualizações conforme disponíveis.

- Recomendamos que os clientes impactados desativem temporariamente o proxy da Cloudflare até que a normalização seja confirmada.

- Para verificar o status do Cloudflare, acesse Downdetector ou a página oficial de status do Cloudflare.

Suporte:

WhatsApp: https://wa.me/11913010000

Ticket: https://painel.napoleon.com.br/

Resumo do Problema:

O repositório de vídeos do Freepik está enfrentando problemas específicos que afetam exclusivamente o download de vídeos. Outros serviços e repositórios da plataforma permanecem operacionais e sem impacto. Os clientes podem experimentar falhas ou lentidão ao tentar acessar os vídeos para download. Estamos monitorando a situação de perto e iremos atualizar conforme novos detalhes surgirem.

Previsão de Normalização:

Sem prazo definido no momento. O status será atualizado assim que o problema for resolvido.

Descrição Técnica:

-

Sintomas Observados:

Os usuários relatam falhas no download de vídeos hospedados no repositório Freepik. Nenhum outro tipo de conteúdo ou repositório foi afetado. -

Ações Iniciais:

Foi realizada uma análise preliminar para verificar a integridade de conexões externas e a funcionalidade dos servidores relacionados ao Freepik. Identificou-se que o problema está limitado ao repositório de vídeos. -

Recursos e Sistemas Afetados:

- Repositório de vídeos do Freepik.

- Serviços de download relacionados a vídeos hospedados na plataforma.

Próximos Passos:

- Continuar monitorando os servidores do Freepik para identificar a causa raiz.

- Trabalhar com a equipe de suporte técnico do Freepik para implementar uma correção.

Atualização: O serviço de downloads dos vídeos está online novamente.

Suporte:

WhatsApp: https://wa.me/11913010000

Ticket: https://painel.napoleon.com.br/submitticket.php

Resumo do Problema:

Estamos enfrentando dificuldades técnicas relacionadas ao repositório de downloads do Freepik. O problema impacta exclusivamente o processo de download de arquivos desta plataforma, enquanto outros serviços permanecem operando normalmente. Nossa equipe já está trabalhando para identificar e resolver a causa do problema.

Previsão de Normalização:

No momento, não há prazo definido para a resolução. Atualizaremos o status assim que houver progresso significativo.

Atualização:

O BOT de vídeos de download do Freepik foi reestabelecido! Qualquer problema ou feedback, só avisar.

Suporte:

WhatsApp: https://wa.me/551191301000

Ticket: https://painel.napoleon.com.br/submitticket.php

Investigando

Identificamos uma interrupção no serviço do WhatsApp, impedindo o recebimento de mensagens enviadas por clientes. O problema está relacionado exclusivamente ao WhatsApp e não afeta outros canais de atendimento.

https://downdetector.com.br/fora-do-ar/whatsapp/

Status sobre a API do WhatsApp Business:

https://metastatus.com/whatsapp-business-api

Investigando.

Resumo do Problema:

O servidor PRO113 enfrentou uma falha de rede que afetou temporariamente o acesso aos sites hospedados. O data center já realizou a correção, e os acessos estão normalizados. A equipe do data center segue investigando para garantir a estabilidade e evitar recorrências.

Previsão de Normalização:

Status: Resolvido. A investigação do servidor continua para análise detalhada, mas os serviços estão operacionais.

Descrição Técnica:

- Sintomas Observados:

Perda de conectividade no servidor PRO113, resultando em indisponibilidade momentânea dos sites. - Ações Iniciais:

O data center atuou prontamente para corrigir a falha de rede, restaurando o acesso. - Recursos e Sistemas Afetados:

Rede do servidor PRO113 e sites hospedados nesse ambiente.

Próximos Passos:

- O time do data center continua a investigar as causas específicas da falha de rede.

- Caso seja identificada a necessidade de intervenções adicionais, os clientes serão informados.

Contato para Suporte: - WhatsApp: https://wa.me/551113010000

- Ticket: https://painel.napoleon.com.br/submitticket.php

Investigando

[Atualização] - Resumo do Problema:

Foi identificado um erro 503 ao acessar os sites hospedados, impactando o funcionamento e a acessibilidade dos serviços. A causa do problema foi uma atualização automática do Imunify, que afetou temporariamente a operação. O incidente já foi resolvido, e os sites estão funcionando normalmente.

Previsão de Normalização:

O problema foi completamente resolvido, e todos os serviços estão operacionais.

Descrição Técnica:

- Sintomas Observados: Os sites retornavam erro 503, impossibilitando o acesso aos serviços hospedados.

- Ações Iniciais: A equipe identificou rapidamente o problema e verificou as atualizações recentes no sistema.

- Causa Identificada: Uma atualização automática do Imunify interferiu no funcionamento dos servidores, causando interrupções temporárias.

- Sistemas Afetados: Todos os sites hospedados no ambiente impactado.

Próximos Passos:

- Revisar as configurações de atualização automática do Imunify para evitar problemas futuros.

- Monitorar o ambiente para garantir a estabilidade.

Suporte:

WhatsApp: Clique aqui

Ticket: Clique aqui

Resumo do Problema:

Foi identificado um problema de intermitência na rede nacional causado por dificuldades de roteamento. A situação está impactando o tráfego de dados em escala nacional, podendo resultar em lentidão ou falhas temporárias de acesso para os clientes. A equipe técnica do data center já está ciente e investigando o problema para identificar a causa raiz e implementar as correções necessárias.

Previsão de Normalização:

No momento, não há uma previsão para a normalização do serviço. Atualizaremos o status assim que houver novas informações.

Descrição Técnica:

- Sintomas Observados: Lentidão ou falhas intermitentes no acesso à rede em âmbito nacional.

- Ações Iniciais: A equipe técnica do data center foi acionada e iniciou a investigação das dificuldades de roteamento.

- Recursos e Sistemas Afetados: Infraestrutura de roteamento e conectividade da rede nacional.

Próximos Passos:

- Continuidade na investigação para identificar a causa raiz do problema.

- Implementação de medidas de mitigação assim que a origem do problema for encontrada.

- Atualizações regulares no status de rede.

[Atualização]: Correção aplicada com sucesso pelo data center. O problema de roteamento foi resolvido, e o serviço está normalizado.

Suporte:

WhatsApp: Clique aqui

Ticket: Clique aqui

Resolvido - 16/11/2024 - 13:18 - O problema foi corrigido. Parece ter sido um cabo de rede a queda. Foi substituído o cabo e subiu o servidor novamente na rede.

Monitorando - 16/11/2024 - 13:16 - A máquina subiu novamente na rede. Estamos monitorando a permanência do servidor ativo.

Atualização - 16/11/2024 - 13:14 - Em andamento.

Identificado - 16/11/2024 - 13:12 - Ainda não foi identificado o problema.

Em investigação - 16/11/2024 - 13:10 - A queda da rede do servidor PRO117.

Prezados clientes,

Em nosso constante compromisso com a excelência e transparência, temos o prazer de informar que estamos realizando uma atualização importante na infraestrutura dos nossos servidores! Esta manutenção foi cuidadosamente planejada para trazer a vocês ainda mais estabilidade, segurança e desempenho em nossos serviços de hosting.

O que vai acontecer?

Estamos transferindo fisicamente alguns de nossos servidores para um novo Data Center, com uma infraestrutura ainda mais robusta. Esse avanço garante que suas aplicações e sites possam continuar crescendo com o suporte de um ambiente de alta performance!

Detalhes da Manutenção:

Data de Início: 16/11 às 00h

Janela de Manutenção: 3 a 5 horas

Servidores que terão intervenção:

pro103.dnspro.com.br

pro104.dnspro.com.br

pro105.dnspro.com.br

pro106.dnspro.com.br

pro107.dnspro.com.br

pro109.dnspro.com.br

pro110.dnspro.com.br

pro111.dnspro.com.br

pro114.dnspro.com.br

pro117.dnspro.com.br

Como funcionará a manutenção:

Para garantir uma transição segura, nossos servidores serão temporariamente desligados até 30 minutos antes do início da janela de manutenção e religados logo após a instalação na nova infraestrutura.

Por que estamos fazendo isso?

Queremos proporcionar a melhor experiência para você! Esta mudança permitirá que nossa equipe suporte seu crescimento de forma ainda mais eficiente, com a confiança de que você está em um ambiente de última geração.

Temos uma equipe dedicada acompanhando cada passo para minimizar qualquer impacto, mas se tiver dúvidas ou precisar de mais informações, nossa equipe de suporte está pronta para ajudar!

Agradecemos sua parceria e confiança em nossa missão de oferecer um serviço de qualidade.

Cordialmente,

Equipe Napoleon Hosting

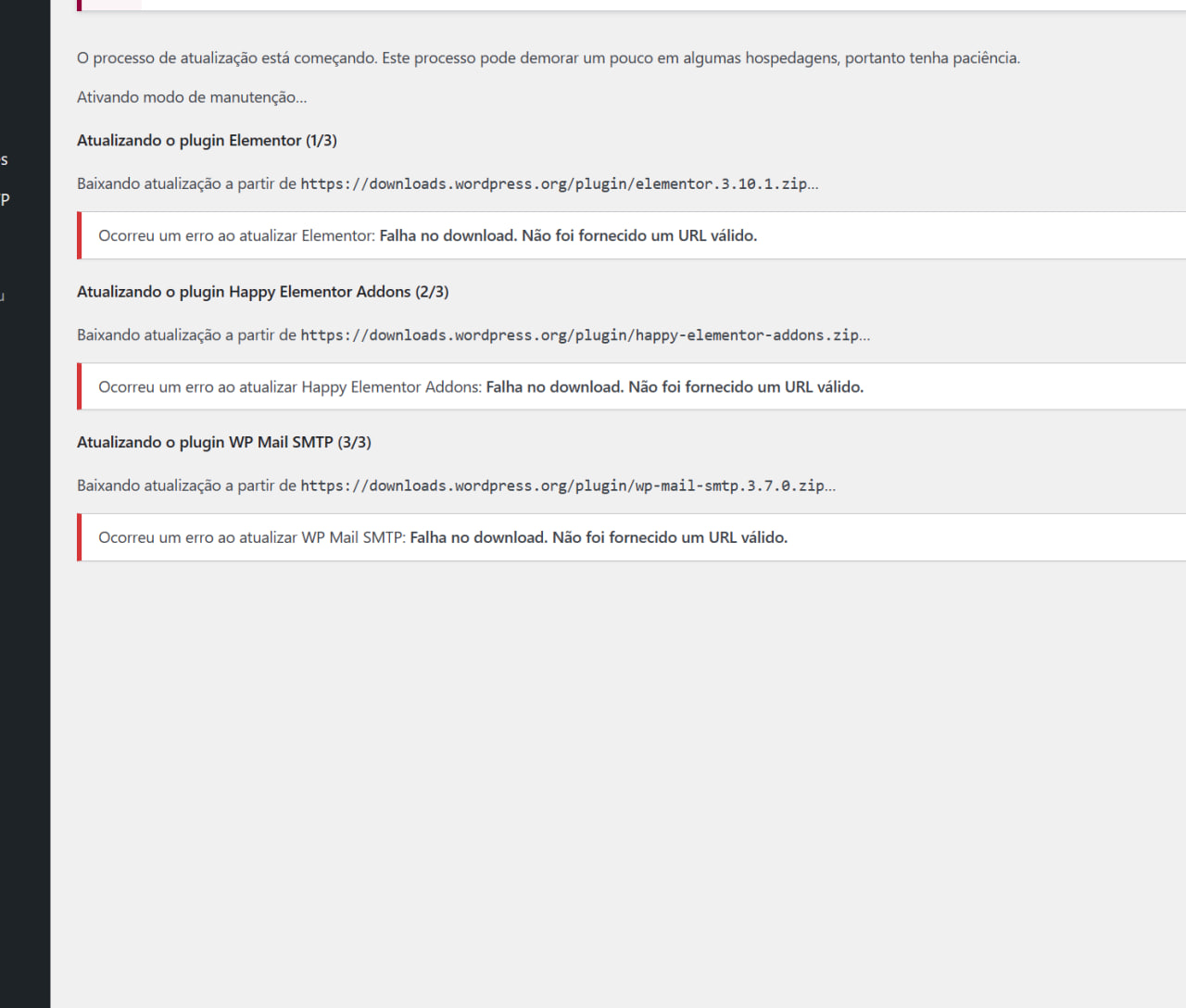

Resumo do Problema:

Ao solicitar a licença do plugin WP Vivid pelo painel, o sistema não realiza o recebimento da licença corretamente. Esse problema impacta os usuários que dependem das funcionalidades de backup e restauração oferecidas pelo plugin.

Previsão de Normalização:

Ainda não há previsão para a normalização do serviço, mas o time de desenvolvimento já está trabalhando na correção.

Descrição Técnica:

- Sintomas Observados: O painel não retorna a licença do plugin WP Vivid quando solicitado.

- Ações Iniciais: A equipe de suporte reportou o problema, e ele foi encaminhado ao time de desenvolvimento para investigação e correção.

- Recursos e Sistemas Afetados: O plugin WP Vivid, com impacto na funcionalidade de backup e restauração.

Próximos Passos:

- O time de desenvolvimento está investigando o problema para identificar a causa e aplicar a correção necessária.

- Assim que houver progresso na solução, uma atualização será publicada nos canais de comunicação.

As atualizações de status serão fornecidas regularmente até a completa normalização.

Atualização [12:00]- Serviço Normalizado:

O problema no recebimento das licenças do plugin WP Vivid foi resolvido. Agora, as licenças estão sendo enviadas automaticamente para os e-mails dos clientes assim que solicitadas pelo painel.

Agradecemos a compreensão de todos!

Contato para Suporte:

- WhatsApp: https://wa.me/551113010000

- Ticket: https://painel.napoleon.com.br/submitticket.php

Resumo do Incidente:

O Storage 13, que atende os servidores pro111, pro107, pro105 e pro103, está passando por uma manutenção programada. Para minimizar o impacto nos serviços, um storage substituto, o Storage 16, foi disponibilizado para backups, que estão sendo gerados regularmente desde o dia 31 de outubro. O impacto da manutenção afeta somente contas encerradas, cujos backups não estão disponíveis temporariamente até a conclusão do trabalho no Storage 13.

Previsão de Normalização:

No momento, não há previsão exata para a finalização da manutenção. A equipe de infraestrutura está monitorando o progresso e fornecerá atualizações conforme necessário.

Descrição Técnica:

- Sintomas Observados: indisponibilidade de backup para contas encerradas no Storage 13.

- Ações Iniciais: foi realizada a migração dos backups ativos para o Storage 16 a partir de 31 de outubro, garantindo a continuidade dos backups em um ambiente seguro.

- Recursos e Sistemas Afetados: o armazenamento de dados para backups de contas encerradas permanece indisponível no Storage 13 enquanto a manutenção está em andamento.

Próximos Passos:

- A equipe técnica está realizando diagnósticos e ajustes no Storage 13 para restaurar a funcionalidade total.

- Backups continuam sendo gerados no Storage 16 para todas as contas ativas.

Novas atualizações serão emitidas à medida que o processo de manutenção evoluir.

Atualização:

[04/11/2024 - 10:59] - O Storage 13 voltou a operar normalmente e já está disponível. A partir de agora, é possível restaurar os backups das contas encerradas.

Contato para Suporte:

- WhatsApp: Clique aqui para WhatsApp

- Ticket: Acessar Painel de Suporte

Update: Estabilizado e em monitoramento.

Identificamos instabilidades de rotas em um de nossos parceiros de data center em São Paulo, afetando algumas regiões do país.

A equipe de engenheiros de rede do data center já está atuando na correção por meio de ajustes nas rotas.

Esperamos que a situação seja normalizada nos próximos minutos, embora ainda não haja um prazo exato informado pelo data center.

Agradecemos pela compreensão e permanecemos à disposição para qualquer esclarecimento.

O Repositório de downloads (Freepik), está passando por uma instabilidade, nossa equipe já está trabalhando para ser resolvido!

Agradecemos a sua compreensão nessa questão, em breve estará funcionando corretamente!

Nosso servidor está estável e não há instabilidades na rede, entretanto vários provedores nacionais estão reportando dificuldades com o transporte até o IX SP, provavelmente esta dificuldade de conexão está afetando sua conectividade, recomendamos que entre em contato com o seu provedor para mais informações.

Estamos cientes das dificuldades e lentidão enfrentadas recentemente no IX do Nic.br, a principal rede de internet nacional para provedores. Gostaríamos de esclarecer que esse problema está afetando a conexão de internet dos usuários até nossos servidores, e não nossos servidores diretamente. Nossa equipe está monitorando a situação e trabalhando para minimizar o impacto em nossos serviços.

Agradecemos sua paciência e compreensão enquanto o Registro.br trabalha para resolver esta situação., segue o link do status:

Em investigação.

Prezados Clientes,

Gostaríamos de expressar nossas sinceras desculpas pelo recente incidente envolvendo o servidor PRO102 e a falha nos backups diários. Entendemos a gravidade da situação e a frustração que isso pode ter gerado. Na Napoleon, nos comprometemos a oferecer serviços de alta qualidade e, infelizmente, neste caso, não conseguimos atender às expectativas de nossos clientes e nem às nossas próprias normas.

Detalhes do Incidente

Em 20 de junho de 2024, às 08:51 (-03), o sistema SMART detectou uma falha em um dos discos NVMe do servidor PRO102. Após análise do Data Center, foi agendada uma janela de manutenção de 3 horas para a troca do disco. Este processo incluiu a remoção do disco do array, desligamento da máquina para substituição física do disco e reconstrução do RAID, sincronizando os dados com o novo disco. A manutenção estava prevista para iniciar em 29 de junho de 2024, às 23:59, e concluir em 30 de junho de 2024, às 03:00.

Durante a manutenção, em 30 de junho de 2024, às 05:35, o Data Center informou que o servidor não reconheceu o novo disco NVMe. Foi necessário realizar um troubleshooting para identificar se seria necessária a troca de todo o chassi do servidor. Nossa equipe manteve contato contínuo com os engenheiros do Data Center, que atuaram diretamente no problema, buscando celeridade em todo o processo.

Como consequência desses problemas de hardware, houve uma falha crítica no sistema de backups, gerenciado pelo software Jetbackup. O incidente resultou na indisponibilidade de dados atualizados para algumas contas cPanel.

Ações Imediatas e Medidas Corretivas

Estamos tomando as seguintes medidas para corrigir a situação e prevenir ocorrências futuras:

-

Investigação Interna:

- Realizamos uma auditoria completa para entender as causas da falha e estamos implementando medidas para assegurar que problemas similares não ocorram novamente.

- Realizamos uma auditoria completa para entender as causas da falha e estamos implementando medidas para assegurar que problemas similares não ocorram novamente.

-

Reforço das Políticas de Backup:

- Revisamos e reforçamos nossas políticas e procedimentos de backup para garantir que sejam seguidos rigorosamente. Estamos também aprimorando nossos sistemas para reduzir o tempo necessário para a geração de novos backups.

- Revisamos e reforçamos nossas políticas e procedimentos de backup para garantir que sejam seguidos rigorosamente. Estamos também aprimorando nossos sistemas para reduzir o tempo necessário para a geração de novos backups.

-

Migração de Infraestrutura:

- Atualmente, 70% da nossa infraestrutura está distribuída em outros cinco Data Centers (DCs) que não apresentam problemas similares. Decidimos não renovar contratos com o Data Center HostDime, onde ocorreram os problemas. Já estamos migrando os serviços para DCs mais confiáveis.

- Atualmente, 70% da nossa infraestrutura está distribuída em outros cinco Data Centers (DCs) que não apresentam problemas similares. Decidimos não renovar contratos com o Data Center HostDime, onde ocorreram os problemas. Já estamos migrando os serviços para DCs mais confiáveis.

-

Recuperação de Dados:

- Já restauramos todos os dados utilizando o backup mais recente disponível. Caso haja defasagem de conteúdo, pedimos que entrem em contato com nossa equipe de suporte para verificarmos se houve algum problema na restauração do backup ou se realmente existe alguma defasagem nas datas de geração do Jetbackup.

- Já restauramos todos os dados utilizando o backup mais recente disponível. Caso haja defasagem de conteúdo, pedimos que entrem em contato com nossa equipe de suporte para verificarmos se houve algum problema na restauração do backup ou se realmente existe alguma defasagem nas datas de geração do Jetbackup.

Solicitação de Informação

Para agilizar a recuperação dos seus dados, pedimos que os clientes afetados entrem em contato com nossa equipe de suporte, especificando os arquivos que precisam ser atualizados. Isso nos permitirá buscar nos discos NVMe anteriores e realizar um rsync o mais breve possível.

Conclusão

Queremos reconquistar a confiança de nossos clientes e assegurar que situações como esta não voltem a ocorrer. Pedimos desculpas pelo transtorno e agradecemos pela compreensão e parceria de sempre. Estamos à disposição para qualquer esclarecimento adicional e para oferecer suporte personalizado conforme necessário.

Atenciosamente,

Equipe Napoleon

---------------------------------------------------------------------------------------------------

Histórico de atuação:

[03/07/2024 - 12:07] - As restaurações foram finalizadas, qualquer dúvida ficamos à completa disposição.

[30/06/2024 - 12:22] - Houve uma nova atualização a respeito da manutenção emergencial que está afetando o servidor PRO102 em nossa plataforma.

1. Qual é o problema?

O servidor possui os discos todos NVMe e durante a troca foi detectado um problema, sendo dessa forma necessária a restauração em um novo servidor.

Durante toda a madrugada nossa equipe e os sys admins do Data Center e tentaram sem sucesso iniciar o ajuste no disco, porém, sem êxito.

Nenhuma das tratativas tiveram êxito, desta forma o mais prudente é restaurarmos as contas em um novo hardware, pois o downtime seria muito maior sem nenhuma certeza de sucesso.

2. O que está sendo feito?

Faremos a restauração dos backups das contas em uma nova máquina. Você receberá por e-mail e ticket informando os novos dados.

Servidor PRO105 <> Novo IP: 187.33.241.40

Servidor PRO121 <> Novo IP: 186.209.113.108

Servidor PRO122 <> Novo IP: 186.209.113.109

A troca de IP só será necessária caso você utilize uma zona de DNS externa, como o Cloudflare, por exemplo, ou outra. Se você não utiliza DNS externo não precisa se preocupar.

3. Como isto afeta os serviços?

Os serviços retornaram gradativamente conforme o restore e apontamento de DNS, se houver necessidade de alteração.

4. Qual a segurança dos dados?

Será utilizado o backup mais recente disponível no Jetbackup para sua conta.

5. Qual o tempo para normalização?

Estimamos que o processo possa demorar algumas horas para finalizar 100% e por isso não temos a previsão exata em horas. Os serviços retornarão de forma gradativa, conforme o restore e apontamento de DNS, se houver necessidade de alteração. Iremos atualizar este status de rede prontamente que existirem novos updates.

Em investigação [30/06/2024 - 05:35] - O Data Center informa que o servidor não reconhece o novo disco NVMe, está sendo feito o troubleshooting para identificar se será necessária uma troca de todo o chassi do servidor. Nossa equipe está em contato com os engenheiros do data center, que estão atuando em hands on, solicitando celeridade em todo o processo.

MANUTENÇÃO [29/06/2024 - 23:59] - O SMART apontou falha em um dos discos NVMe deste servidor e após análise do Data Center foi agendada uma janela de manutenção de 3 horas para a troca do disco que consiste em removê-lo do array, desligar a máquina para substituição física do disco e então reconstruir o RAID sincronizando os dados com o novo disco.

Início: 29/06/2024 - 23:59 - Conclusão: 30/06/2024 - 03:00

Detectamos recentemente algumas inconsistências de hardware no servidor onde seus serviços estão atualmente hospedados (PRO108, problemas os quais não foram solucionados com a reposição de peças incluindo placa mãe). Nós acreditamos na importância de agir de forma preventiva para garantir a qualidade e segurança dos seus dados.

Por isso, decidimos que será benéfico para você migrar os seus dados para um novo e mais moderno servidor. Esta atualização não só proporcionará maior estabilidade e segurança, como também oferecerá um melhor desempenho e uma resposta mais rápida, o que acreditamos que irá melhorar ainda mais sua experiência aqui conosco.

Além disso, foi enviado um e-mail na data de hoje, 13/06/2024 (quinta-feira), avisando também sobre o procedimento que será realizado.

A migração será iniciada às 22 horas (horário de Brasília) na próxima sexta-feira (14/06/2024), a nossa equipe irá realizar a migração de forma gradativa para um novo servidor, nós iremos avisar quando finalizarmos, será aberto um ticket e você receberá no e-mail de cadastro também a informação a respeito da finalização sobre sua migração.

Nosso objetivo é que este processo de migração seja o mais tranquilo possível. Nossa equipe técnica se encarregará de realizar esta transição de forma eficiente e segura, procurando evitar qualquer tempo de inatividade ou interrupção de seus serviços.

Caso utilize o Cloudflare ou uma outra zona de DNS externa, o novo IP para substituição sera este: 186.209.113.107.

OBS: A troca deve ser realizada somente após a migração ser finalizada.

Estamos sempre à disposição para ajudá-lo. Caso tenha qualquer dúvida ou preocupação sobre este processo de migração, por favor, não hesite em entrar em contato conosco. Nossa equipe de suporte está pronta para auxiliá-lo em qualquer momento.

Agradecemos sua compreensão e apoio contínuos. Estamos confiantes de que esta migração trará benefícios significativos para você.

Atualização: Migrações finalizadas com sucesso! Quaisquer dúvidas que surgirem, ficamos à completa disposição.

Nesta madrugada do dia 11/06/2024 será realizada uma manutenção emergencial no servidor PRO108.

O que será feito?

Foi detectada uma falha em um setor da placa mãe deste servidor na última janela de manutenção, desta forma procedemos com a substituição da mesma nesta janela.

Prazo: 3 horas e 15 minutos.

Horário de início às 23:45 do dia 10/06/2024.

Horário de finalização às 03:00 do dia 11/06/2024.

Já em processo de mitigação.

Será realizada uma manutenção no servidor PRO108 nesta madrugada do dia 05/06/2024, será feita uma verificação da fonte de alimentação.

Prazo de 2 horas.

Início às 01:45 da madrugada do dia 05/06/2024.

Finalização às 03:45 da madrugada do dia 05/06/2024.

Atualização - 05/06 - 02:26 - O processo de manutenção foi abortado pela equipe do Data Center, já estamos agendando uma nova janela de manutenção que será atualizada em breve.

Atualização - 06/06 -13:48 - O processo de manutenção será realizado na madrugada do dia 06/06 às 0h00 (meia-noite), com prazo de 2 horas até às 02:00 da madrugada do mesmo (06/06).

Início às 00:00 da madrugada do dia 06/06/2024.

Finalização às 02:00 da madrugada do dia 06/06/2024.

Manutenção programada para madrugada de sábado para domingo.

Será realizada uma manutenção para a troca de um pente de memória no servidor Pro116.

Previsão de finalização: 1 hora

Horário de início: 26/05 às 00:45 até às 01:45

Última atualização:

19h31 - Após todas as análises a rede encontra-se estável desde 19h06. Muito obrigado =)

19h06 - A rede subiu novamente, mas ainda passando por análises.

18h59 - Ainda em andamento. Pedimos desculpas pela inconveniência.

18h29 - O time de infraestrutura e redes continua em cima da máquina. Parece ser um problema pontual de redes que está afetando esta máquina. Já estamos atuando para resolver.

17h59 - Em análise.

Há uma instabilidade junto ao LiteSpeed Enterprise que esta sendo investigado pela desenvolvedora. Fizemos o update da última versão, mas mesmo assim não foi resolvido por completo.

Prazo: 15h15 até as 17h00

Devido às recentes falhas na rede da HostDime SP01 causadas por ataques DDoS que nunca visaram diretamente nossos servidores, mas acabaram afetando toda a rede, enfrentamos diversos impactos.

Após várias reuniões com o Data Center, chegamos a um consenso sobre uma solução que envolve a troca do bloco de IPs dos nossos servidores. Em caráter de EMERGÊNCIA, alteramos o IP do seu servidor para o IP abaixo:

Servidor PRO102 - 187.33.241.31

Servidor PRO103 - 187.33.241.34

Servidor PRO104 - 187.33.241.37

Servidor PRO105 - 187.33.241.40

Servidor PRO106 - 187.33.241.43

Servidor PRO107 - 187.33.241.46

Servidor PRO109 - 187.33.241.49

Servidor PRO110 - 187.33.241.52

Servidor PRO114 - 187.33.241.58

Se você estiver utilizando o Cloudflare ou qualquer outra zona de DNS externa, por favor, corrija o apontamento imediatamente. Se estiver utilizando o nosso cluster de DNS, nenhuma alteração é necessária.

A IUGU (gateway de pagamento) está com problemas para gerar PIX, Boletos e pagamentos via cartão.

Segue o link do status deles:

https://status.iugu.com/incidents/rvzgbkmczqk5

Previsão: Até às 15:55 hrs para normalização.

Mitigação de tráfego na rede de entrada para serviços Web.

Estamos com instabilidade de rede em apenas uma parte de nossa infraestrutura em São Paulo devido a ataques massivos DDoS que estão sendo direcionados a ranges aleatórios ao Data Center SP01.

Importante: Não há qualquer ataque direcionado aos nossos servidores assim como os dados estão devidamente preservados.

Histórico 12/03:

Na noite de ontem foi trocado o Peering de Proteção para outro fornecedor (UPX + SAGE) e agora o nosso Data Center atua em ajustar os filtros desta nova proteção que é mais robusta e confiável.

Você ainda sente instabilidades porque Ataques DDoS são dinâmicos e neste caso específico o ataque está persistente com uma média de 200 GB/s, desta forma os filtros são ajustados para ser mais efetivo quando o ataque muda suas características.

Atualizado: (1.0) Nossa equipe esta diretamente em contato com os engenheiros de rede do Data Center realizando a solicitações de alterações de rotas e ajuste fino dos filtros para que os transtornos sejam minimizados até que o ataque seja 100% mitigado.

(1.1) Será realizada uma manobra na rede do servidor onde será trocado o fornecimento de link e proteção anti-ddos em uma nova faixa de IP, assim que houver novos detalhes e mais informações atualizamos aqui no nosso status de rede.

Investigado

Há um bug na plataforma cPanel relacionada a função Listar contas de e-mail no cPanel e então acessar o webmail a partir desta listagem.

O bug já está sendo investigado pela cPanel e será corrigido em breve, enquanto isto faça acesso à conta de e-mail diretamente ao webmail a partir das URLs:

www.seudominio.com.br/webmail ou webmail.seudominio.com.br

O sistema do meio de pagamento IUGU, responsável pelo boleto bancário, PIX e cartão de crédito recorrente esta offline na parte de invoices até o momento.

Já comunicamos o time de desenvolvimento deles e estamos aguardando um retorno e solução para o problema.

Qual é o problema?

O servidor possui os discos todos NVMe e o kernel do Cloudlinux apresentou um bug que leva a reinicialização até corrompimento do sistema de arquivos.

Após extensa investigação foi disponibilizado um patch pelo Cloudlinux que foi aplicado com sucesso em todos os servidores com sistema operacional Alma 8. Já neste servidor é utilizado CentOS 7.9 e o kernel da Cloudlinux foi codificado com uma extensão que corrompeu todo o sistema do servidor.

Durante toda a madrugada nossa equipe, os sys admins do Data Center e os engenheiros sêniors da Cloudlinux tentaram sem sucesso iniciar a máquina.

Nenhuma das tratativas tiveram êxito, desta forma o mais prudente é restaurarmos as contas em um novo hardware, pois o downtime seria muito maior sem nenhuma certeza de sucesso.

O que está sendo feito?

Faremos a restauração dos backups das contas em uma nova máquina.

Como isto afeta os serviços?

Os serviços retornaram gradativamente de acordo com o restore e apontamento de DNS, se houver necessidade de alteração.

Qual a segurança dos dados?

O servidor atual não é confiável e não pode ser utilizar para cópia, desta forma será utilizado o backup mais recente disponível no JetBackup para sua conta.

Qual o tempo para normalização?

Estimamos que o processo possa demorar até 36 horas para ser concluído. Os serviços retornaram gradativamente de acordo com o restore e apontamento de DNS, se houver necessidade de alteração.

Progresso:

--> 100% das contas já restauradas. Você recebeu um ticket e um email informando os novos dados de acesso e IP.

20/02/2024

21h49 - Restauração finalizada dos bancos de dados MySQL do servidor.

Resumo Prévio: Parece que o problema se originou no Kernel do Cloudlinux. O qual ainda esta sob investigação do time da CL. Com isso, a máquina ficava fazendo o boot e reiniciando na sequência. Então não era nenhum problema de hardware e sim do Kernel. Voltamos uma versão anterior para podermos dar vazão e analisar os logs. A troca de chassi foi suspensa durante esta tentativa bem sucedida de voltar o Kernel. Se o problema voltar a ocorrer neste meio tempo, a troca de chassi é iminente.

16h34 - Banco de dados MySQL ainda em restauração.

15h35 - Validando um kernel anterior + banco de dados.

14h33 - Iniciado o procedimento de troca de chassis e placa de rede.

13h57 - Os serviços web continuam desativados intencionalmente para manter a máquina ativa, enquanto finalizamos todos os testes.

13h20 - A máquina voltou a reiniciar, estaremos fazendo um full chassi swap.

13h02 - A máquina voltou a ficar online e disponível. A funcionalidade de backup via cPanel ou Jetbackup estará indisponível até finalizarmos 100% os testes e verificações.

12h30 - Finalizado os testes de hardware e não foi encontrado nenhum problema. O time de rede esta verificando a rede pública da máquina.

11h40 - A máquina está na bancada sendo analisado possíveis problemas de hardware.

10h06 - Análise e testes de software com testes de estresse para verificar o motivo dela estar reiniciando. Pois o problema parece ser outro.

05h36 - Após receber um ataque DDoS nesta madrugada, mesmo com a proteção segurando o ataque, o servidor estava entrando em loop e reiniciando. Correndo o risco de corromper o sistema (kernel). Desta forma foi desativada a porta pública da máquina até finalização de investigação. O servidor esta online e com os dados preservados.

PRO105

14/02/2024 - Por conta do problema de hardware, decidimos inutilizar esta máquina, migrando todos os clientes para máquinas novas e modernas. Depois de 100% finalizada as migrações, estaremos substituindo 100% do hardware.

PRO101

14/02/2024 - Ainda em andamento as migrações do Data Center Canadá para o nosso DC Brasil.

05/02/2024 - Ainda em andamento as migrações do Data Center Canadá para o nosso DC Brasil.

24/01/2024 - Ainda em andamento as migrações do Data Center Canadá para o nosso DC Brasil.

20/01/2024 - Iniciamos as migrações do DC Canadá para o nosso DC Brasil.

19/01/2024 - Identificado o problema.

16h45 - O serviço foi retornado em poucos minutos após desbloqueio do IP. Estamos em tratativa com o Data Center para entender a ocorrência.

16h21 - Em investigação.

18h48 - Parece ter retornado, ou a operadora mitigado. Detalhe interessante que acesso pela VIVO de São Paulo acima estava com este problema. VIVO Sul já estava funcionando normalmente. Repassamos essa info a operadora.

18h39 - Ataque massivo DDoS nessa rede utilizada pela Vivo. Já falamos com a operadora.

18h30 - Estamos investigando com o Data Center o motivo da queda. Todos os servidores estão funcionando, apenas é algo na rede com a VIVO. Parece ser o link da VIVO que perdeu acesso. Acesso pela Claro e outras operadoras esta normal.

Já iniciou a mitigação do ataque na rede. Em breve teremos novidades aqui no status.

A Iugu (Gateway) parece estar com problemas no faturamento e pagamento de PIX e Boleto bancário. Já acionamos o time de infra-estrutura do gateway para validação.

Caso você tenha urgência na ativação, entre em contato com o nosso suporte.

Já acionamos o time do PicPay que ainda esta buscando uma solução.

Olá, como vai?

Um de nossos storages está com dificuldades de funcionamento que ocasionou alertas novamente de monitoramento. E agora esta novamente passando por fsck. Suspeitamos que seja algo relacionado com o rebuild do disco que foi substítuido outro dia.

Por conta disso, estaremos realizando a formatação do disco para resolução definitiva do problema.

Servidores que dependem deste Storage:

PRO106

PRO107

PRO109

PRO111

Qualquer dúvida ficamos a completa disposição,

⠀⠀⠀⠀⠀⠀⠀⠀

Equipe de Atendimento ao Cliente

Napoleon - Hospedagem e Revenda Dedicada, Servidores Cloud e Bare Metal.

-

Suporte Online:

Olá, como vai?

Na noite de hoje, realizaremos o update do banco de dados do MariaDB 10.3 para versão 10.6 com uma janela de manutenção de 2 horas, em média. O processo gerará instabilidades no acesso ao serviço de banco de dados.

Qualquer dúvida ficamos a completa disposição,

⠀⠀⠀⠀⠀⠀⠀⠀

Equipe de Atendimento ao Cliente

Napoleon - Hospedagem e Revenda Dedicada, Servidores Cloud e Bare Metal.

-

Suporte Online:

Olá, como vai?

O disco do Storage (backup) do Servidor PRO111 houve falha física e estará sendo substituído na data de hoje, 13/12/2023 - Quarta-feira, pois consta o mesmo modelo em estoque.

Antes da data do início da falha 11/12/2023, os backups continuam preservados e podem ser restaurados normalmente.

Assim que for substituído o disco estaremos atualizando o status desta demanda.

Qualquer dúvida ficamos a completa disposição,

⠀⠀⠀⠀⠀⠀⠀⠀

Equipe de Atendimento ao Cliente

Napoleon - Hospedagem e Revenda Dedicada, Servidores Cloud e Bare Metal.

-

Suporte Online:

Olá,

A base de nossa parceria, além de oferecer a melhor infraestrutura para seus serviços, é, também, fortalecer a transparência de informações, por isso gostaríamos de informar sobre uma manutenção emergencial na infraestrutura de rede onde está alocado os seus serviços conosco.

A manutenção ocorrerá hoje, dia 23 de novembro de 2023. Por gentileza, leia atentamente este comunicado e esteja ciente das ações desta ação.

Tipo de manutenção:

Melhoria de performance no fluxo de rede.

Janela de Manutenção:

Início: Quinta-feira, 23 de novembro de 2023 às 23h59min (Horário de Brasília).

Término: Sexta-feira, 24 de novembro de 2023 às 01h00min (Horário de Brasília).

Tempo de instabilidade:

Durante a janela de manutenção não é esperada indisponibilidade de rede. Porém, é possível que em alguns momentos você note uma breve degradação de performance. Caso isso ocorra, nossos engenheiros de rede estarão acompanhando em tempo real o procedimento e caso necessário, a intervenção será imediata.

Caso tenha mais alguma dúvida referente ao procedimento de manutenção, é só entrar em contato conosco.

Atenciosamente,

Equipe Napoleon

16h08 - Resolvido o upload e download no link principal. Foi necessária uma troca física do link de fibra para fugirmos do link que estava com problemas via Telefônica. E o link de contingência que existia também estava com este mesmo problema, por conta disso foi demorada a solução, visto ser necessário alterar fisicamente a fibra.

-

15h43 - Ainda em andamento a propagação das alterações. Rede instável.

-

13h24 - Isolando problema com a Tely (rota de conexão com o DC).

-

12h50 - Identificado o problema de rota do DC de São Paulo da Lúmen (Cirion). Em atuação com o time de infra e rota da Telefônica.

-

11h39 - Nossos servidores estão online e estáveis, entretanto estamos recebendo reports de falhas de rede de usuários que utilizam Vivo ou rotas da Telefônica:

https://downdetector.com.br/fora-do-ar/vivo/: Por favor verifique junto ao seu provedor.

Apenas comunicando que o serviço do Freepik esta instável conforme relatado: https://downdetector.com/status/freepik/

//Atualização - 19h11

Identificamos uma falha na placa mãe do antigo servidor e realizamos uma troca completa do hardware. O acesso foi normalizado e faremos a migração gradual de todas as contas para um servidor novo. Durante este processo os procedimentos de backup por parte dos usuários estão suspensos e estarão liberados no servidor novo.

Assim que for migrado será necessário que caso esteja no Cloudflare, ou aponte para o IP, precisará alterar para o novo IP, enviaremos um ticket sobre a migração e também em seu e-mail os dados de acesso, logo quando for realizada a migração, ela será feita aos poucos, mas no momento, já conseguirão acessar seu servidor.

Terça-feira: 12/09/2023

// Atualização - 13h10

Status da cópia: 18%

Prazo previsto: 50 horas

// Estamos finalizando a cópia do disco para liberar a maquina. Foi implantado um novo NVMe.

Segunda-feira: 11/09/2023

// Atualização - 00h56

Status: fsck finalizou e agora estamos clonando o disco.

// Atualização - 20h17

Ainda esta rodando o comando. Previsão para as 22 horas a finalização. O horário é apenas uma previsão e pode sofrer alterações.

// Atualização - 12h50